深入淺出Prompt Learning要旨及常用方法

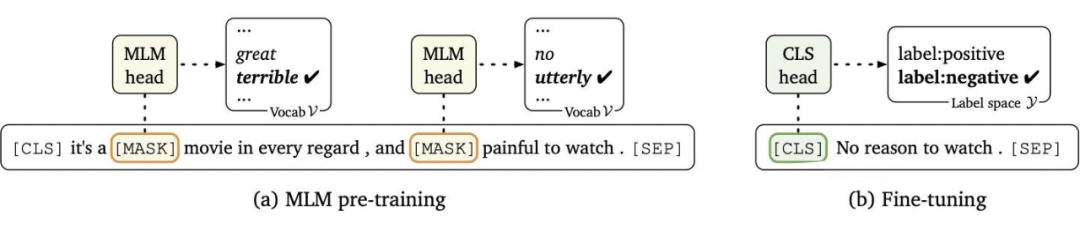

NLP的訓(xùn)練范式有哪些

提示學(xué)習(xí)是什么

- 設(shè)計預(yù)訓(xùn)練語言模型的任務(wù)

- 設(shè)計輸入模板樣式(Prompt Engineering)

設(shè)計 label 樣式及模型的輸出映射到 label 的方式(Answer Engineering)

# AI應(yīng)用信息# AI# BERT# ChatGPT# GPT# GPT-3# LSTM# NLP# prompt# 機(jī)器學(xué)習(xí)# 深度學(xué)習(xí)# 研究成果# 預(yù)訓(xùn)練模型

? 版權(quán)聲明

本文轉(zhuǎn)載自互聯(lián)網(wǎng)、僅供學(xué)習(xí)交流,內(nèi)容版權(quán)歸原作者所有,如涉作品、版權(quán)或其它疑問請聯(lián)系AIGC工具導(dǎo)航或點擊刪除。

.png) ?津公網(wǎng)安備12011002023007號

?津公網(wǎng)安備12011002023007號